五反田で開催されないと定評のある『Gotanda.unity #8 in ワンダープラネット株式会社 @渋谷』に行ってきたので雑なメモと、拾えただけのスライドを貼っておきます。

LT #1 シンプルStateMachine

@k-wth さん

- ステートマシン"1号"、シンプルなうちはよかったが、Stateの入れ子など複雑化し、バグの温床に

- シンプルな"2号"を作った

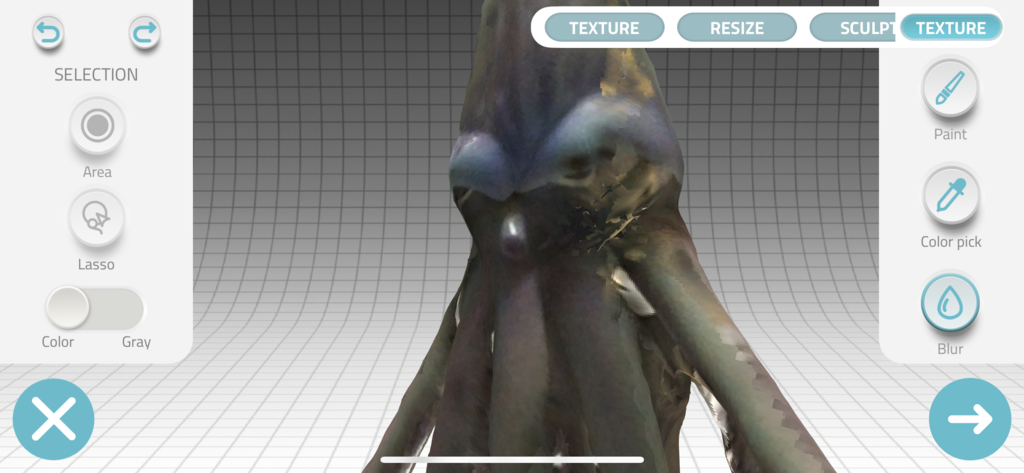

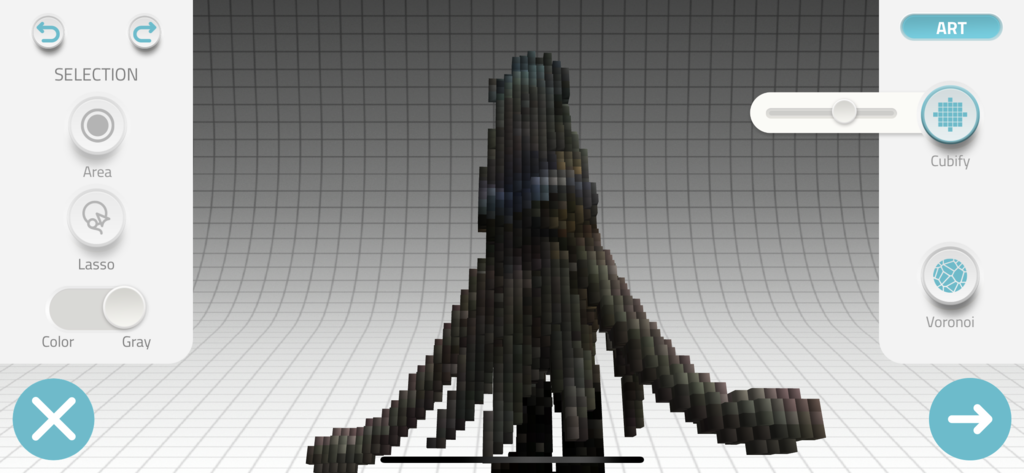

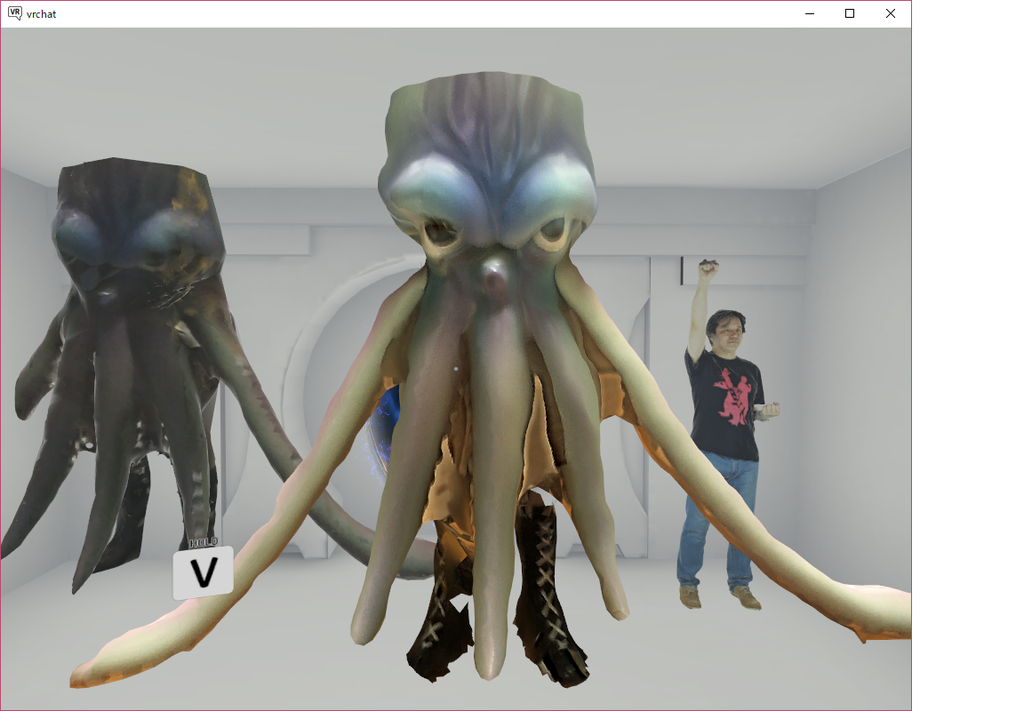

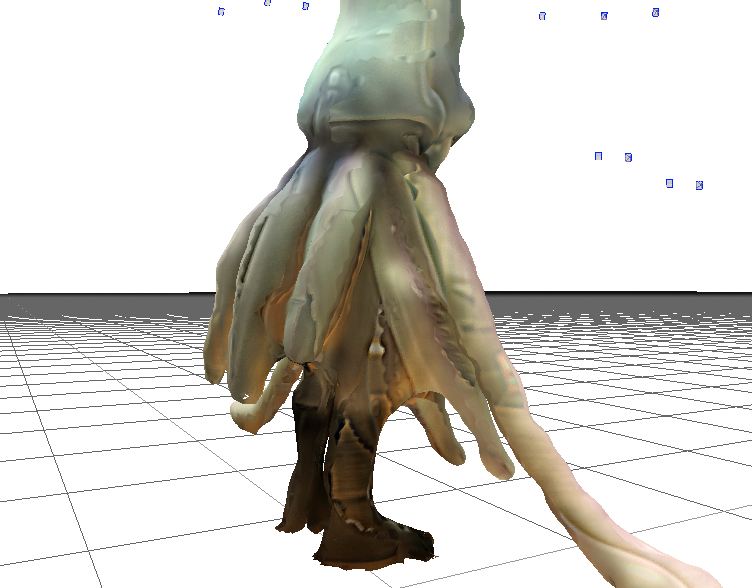

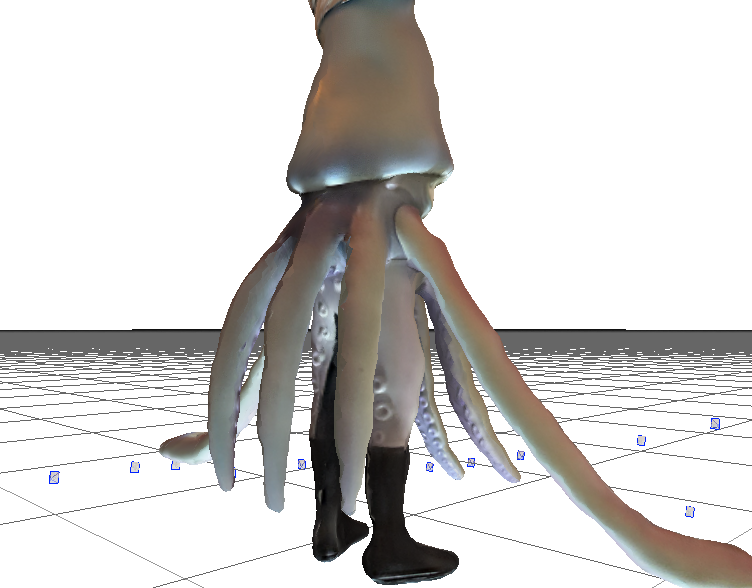

LT #2 シェーダー芸・入門から1ヶ月の道のり

@nimu026 さん

- 8月のJAPANLAND花火大会@VRChatに触発されてシェーダ芸を

- Shurikenでなく、GPUパーティクル? シェーダ芸?

- Compute ShaderはVRChatに持ち込めない

- phiさんのシェーダ芸

- Vertex Shaderでもなく、Fragment Shaderでもなく、Geometry Shader

- Geometry Shaderで動かしてFragment Shaderで塗る

- ひたすら写経したり改変したり

LT #3 NCMBでオートログインとセーブデータのバックアップ

@azumagoro さん

- 個人開発ゲーム。v1はローカル保存、v2からNCMB

- JsonUtilityでシリアライズ。EasySaveではList<>を保存できない

- masterから取得できるデータはkeyだけ持っておく(節約)

- NCMBの課金体系が変更されて痛い

LT #4 ObservableパターンからはじめるUniRx

@torisoup さん

- Observerパターン

- ObserverとSubject、印象が逆なので注意。Subject側が管理してる。Observerは監視・管理はしていない

LT #5 PUN2触ってみた

@otyugen59 さん

- Photon Unity Networking

- PUN2が8/25リリース

- PhotonRx(とりすーぷさん作)

- コールバックが変更されているのが一番影響大きい

PUN は 開発者の Tobias はパンと発音してたけど、日本ではピーユーエヌって読む人が多い気がする

— やまさん(S.Yama) (@syyama_net) 2018年9月26日

LT #6 ここが楽しい/しんどいLive2D CubismSDK for Unity

@traitam さん

- v2.1とv3.0で互換性がない

- "うちの子・推しを動かせる"のが一番楽しいところ

- ドキュメント、情報発信者が少ない(Editorの話はあるけど)

- 畑を耕さないと

LT #7 Tilemapのアップデートについて

@RyotaMurohoshi さん

早速ブログ記事も

- 2018.2から、Hexagonal Tile

- Isometric Tile

- クォータービュー

- まだベータ

- オクルージョンできる。高さがある

こういうのやりたくないですか!#gotandaunity pic.twitter.com/1H6NBl5qH8

— むろほし (@RyotaMurohoshi) 2018年9月26日

- Let's 人柱!

LT #8 スコープファンクションでコードの見通しを改善する

@yashims85 さん

- 関数に切り出すほどでもないもの*1

- Kotlinの文脈で出てくる

- 引数にselfを渡して、Lambdaの中でプロパティをセットするなどして、selfを返す

- Also(that => {that.x=0;... return that} とか

- 一時変数が減ってコードの見通しが良くなる

- Null安全

LT #9 4画面出力とレシート印刷で作る体験型デジタルサイネージ

@ksk1030 さん

- マルチディスプレイ

- ディスプレイごとの設定、リフレッシュレート、アス比

- UnityのindexとOS上の番号が一以しない。ケーブル挿す順で変わる?

- レシートプリンタ

- Windowsタッチパネルのエッジスワイプを抑止したい→物理的に抑止した

LT #10 Scene操作系のエディター拡張Util2セット

@takumi_hanzawa さん

www.slideshare.net

- マルチシーンエディティングで、アクティブを切り替えるのを2クリック→1クリックに

- シーンの読み込み履歴。ヒストリーウィンドウで1クリックでロード

所感

LT10本、Unityの扱う領域の広さをあらわすように、幅広く、話の被りもなく、とても面白い回でした。

聞いた話が役に立つ日が来るのか?と言われると、まず無い、と言い切れるトークが多かったのですが、それはそれ。役に立つ話を聞くばかりが勉強会ではないと思っているので、このノリは引っ張ってほしいところです。

なかでも、マイノリティな技術の孤立無援っぽい話は共感するところもあり、それでも「畑を耕さないと」「Let's 人柱!」といった前向きな言葉がよかった。

また次回は2ヶ月後ということで、何かネタがあればまた登壇も検討しようかという気持ちになったと同時に、前々回のフォローアップ記事をまだ書いてないことを思い出したり…

関連資料

- 作者: 吉谷幹人,布留川英一,一條貴彰,西森丈俊,藤岡裕吾,室星亮太,車谷勇人,湊新平,土屋つかさ,黒河優介,中村優一,牙竜,コポコポ,かせ,hataken,monmoko,佐藤英一

- 出版社/メーカー: ボーンデジタル

- 発売日: 2018/05/01

- メディア: 大型本

- この商品を含むブログを見る

*1:個人的には「関数に切り出すほどでもないもの」は関数に切り出すほうが好きです。テスト書きやすいし